Lucide.ai : le test du détecteur d’IA made in France !

2023 a été l’année où l’IA a bouleversé nos quotidiens et notamment mon travail. Étant rédactrice Web depuis près de 12 ans, avoir la machine comme concurrent était quelque peu effrayant. Il a fallu s’adapter aux nouvelles attentes des clients et à leurs exigences. Si certains sont ouverts à l’idée de publier des articles générés par ChatGPT, d’autres n’en veulent pas.

Ce n’est donc pas surprenant qu’un détecteur d’IA soit au rendez-vous. Il se nomme Lucide et il a été développé Arthur. Plongeons au cœur de cet outil afin de le décortiquer.

C’est quoi Lucide.ai ?

Face à la recrudescence des textes issus de l’IA, certains ont lancé des logiciels pour repérer les patterns. Arthur qui fait partie des Wizards (organisateurs du Wizards Event 2024 et à l’origine du Podcast avec Franck (@frk_nft) et Anthony (@antho_soum)) s’est focalisé sur cette tâche en donnant vie à Lucide.

Arthur (@ZalidanTV) à l’origine des sociétés Impact IM, Pappleweb et fin consommateur d’IA depuis de longs mois avait besoin d’un outil pour identifier l’intelligence artificielle au sein des contenus. C’est donc la promesse, mais est-elle tenue ?

Et niveau tarifs, c’est cher ?

3 packs sont disponibles pour répondre à toutes les attentes.

- Découverte, le pack de 100 crédits à 9 euros HT

- Essentiel, le pack de 385 crédits à 27 euros HT

- Avancé, le pack de 670 crédits à 47 euros HT

- Expert, le pack à 1385 crédits à 97 euros HT

- Elite, le pack de 2385 crédits à 167 euros HT

- Entreprise, le pack de 5570 crédits à 390 euros HT

L’abonnement se démarque avec en supplément l’accès à l’API ainsi que la recharge de crédits. Vous bénéficiez d’un nombre illimité de projets. Au niveau des contraintes, le scan commence avec 100 mots minimum et jusqu’à 3500 mots.

Généralement, dans la rédaction Web, nous parlons plutôt de textes de 500 mots. Avec cette base, on obtient ces tarifs sur Lucide.ai.

- Abonnement : 25 centimes par texte.

- Starter : 45 centimes par texte.

- Pro : 35 centimes par texte.

Par rapport au prix facturé par un rédacteur, Lucide est vraiment abordable. Que ce soit pour une vérification ponctuelle ou récurrente, cet outil ne vous coûtera pas un bras. Par contre, si vous commandez 50 000 mots par mois, je vous conseille l’abonnement, il sera beaucoup plus économique.

Petite astuce : si toutefois, vous dépassez le quota avec l’abonnement, la recharge est possible, le tarif sera plus faible que si vous optez pour deux commandes Pro par exemple.

Comment fonctionne ce détecteur d’IA ?

Votre compte est donc crédité, passons aux choses sérieuses. Premier point fort, l’interface. Elle est fluide et facile à prendre en main.

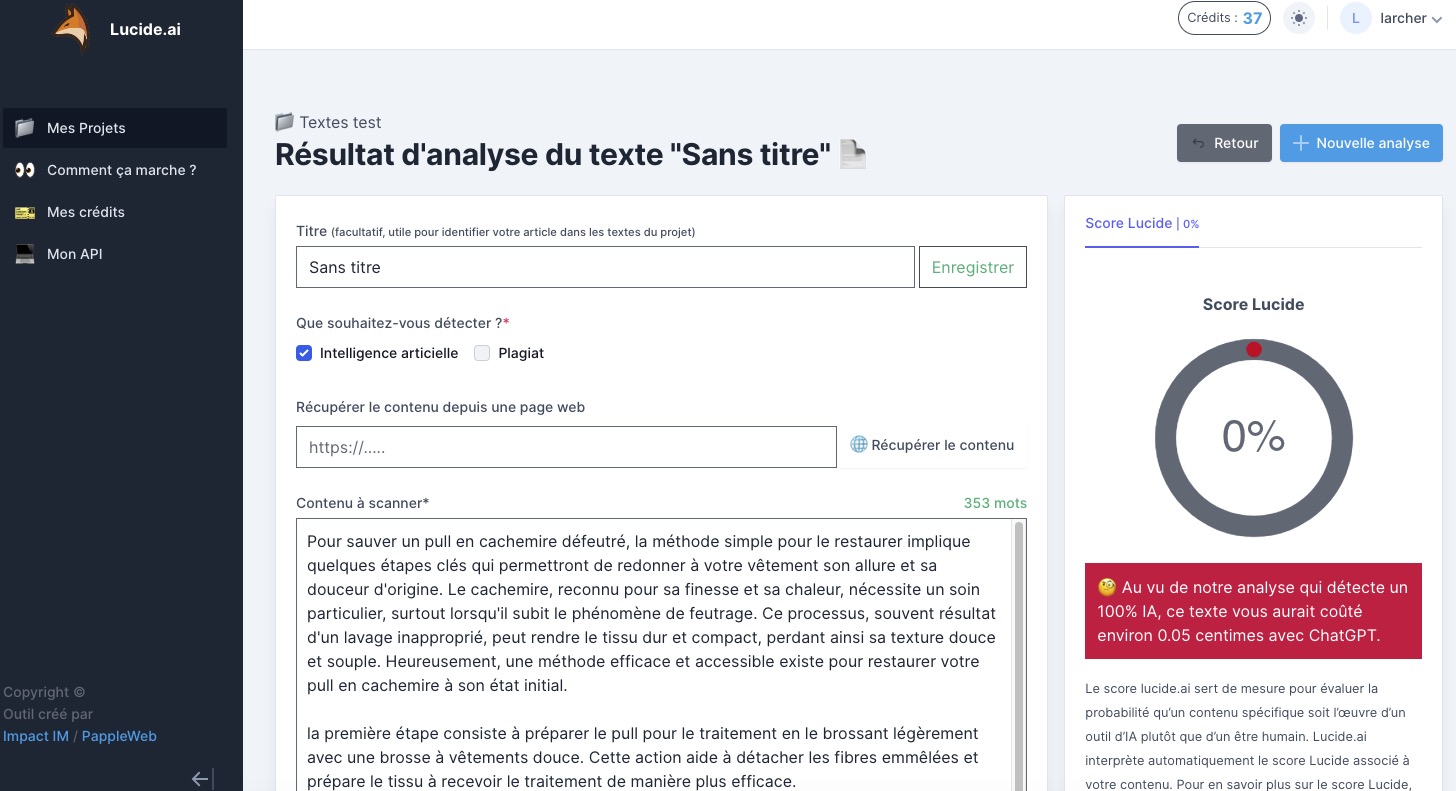

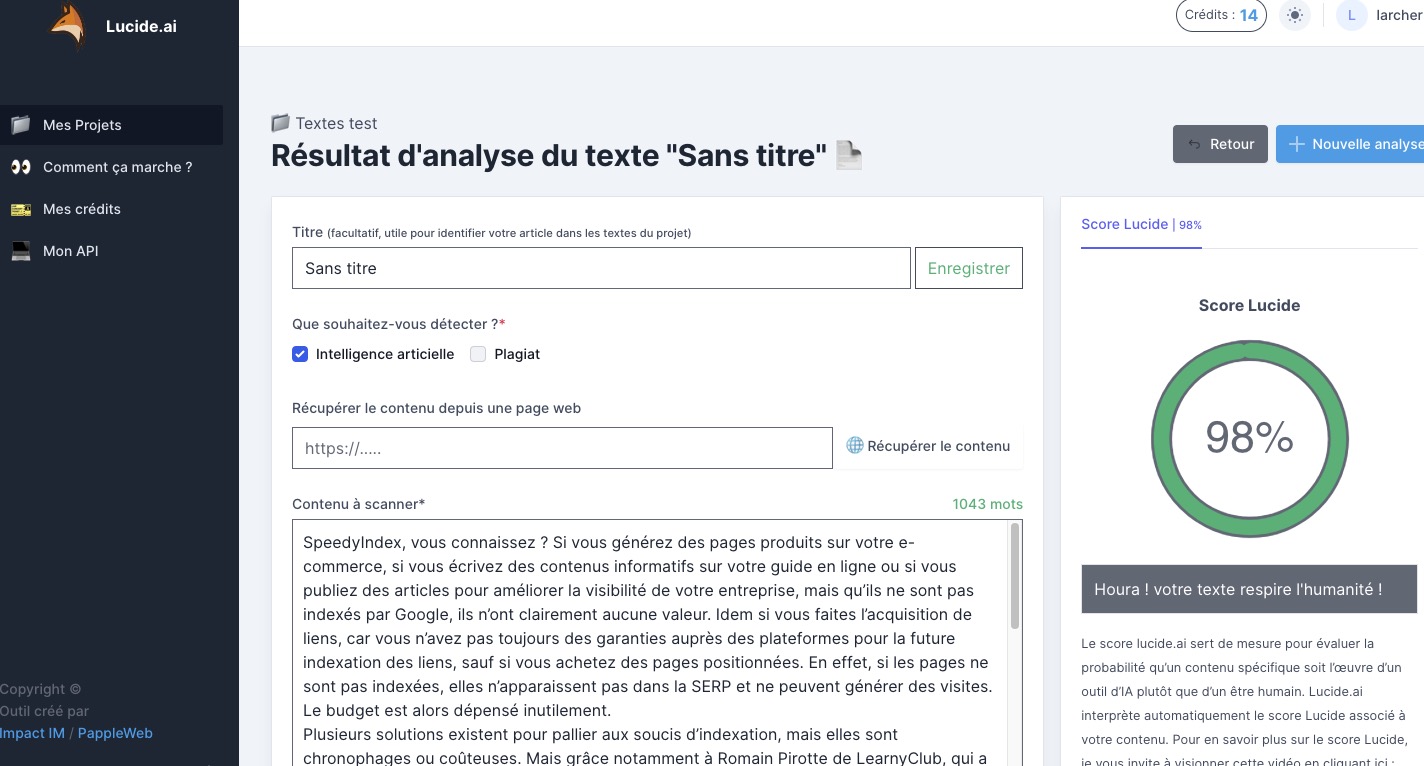

Après avoir créé un projet, vous débarquez sur l’éditeur qui vous permet de détecter l’intelligence artificielle et même le plagiat. Soit vous récupérez le contenu via l’URL, soit vous copiez/collez le texte dans l’éditeur.

N’oubliez pas le minimum de 100 mots et le maximum de 3500 mots. Lancez la détection et quelques secondes plus tard, vous obtenez le score à droite. En fonction du nombre de mots, l’outil vous rappelle les crédits consommés. Par contre, le titre de l’article n’est pas analysé, il est donc facultatif.

Grâce au score, vous savez normalement si le texte est issu de l’IA, d’un rédacteur offshore ou d’un professionnel expérimenté.

Quelques questions avant le test approfondi

- Version d’essai gratuite ? Non l’offre à 9 euros vous permet de réaliser plusieurs tests.

- Se désabonner n’importe quand ? Aucun engagement, vous arrêtez dès que vous le souhaitez.

- À qui s’adresse Lucide AI ? Agences Web, éditeurs de sites, rédacteurs, marques…

- Disponible dans plusieurs langues ? Compatible uniquement avec le français.

- Historique des textes ? Tous les articles scannés sont conservés dans le projet.

- Date d’expiration des crédits ? Avec l’abonnement, ils se renouvellent tous les mois. Pour les packs, ils ont une durée de vie d’un an.

- Pour l’API, faut-il l’abonnement ? Oui.

- Prochaines évolutions ? Plugin WordPress et extension Google Docs sont en préparation.

Est-ce vraiment fiable pour détecter l’IA ?

J’ai réalisé plusieurs tests pour savoir si Lucide détectait vraiment l’humain et l’IA.

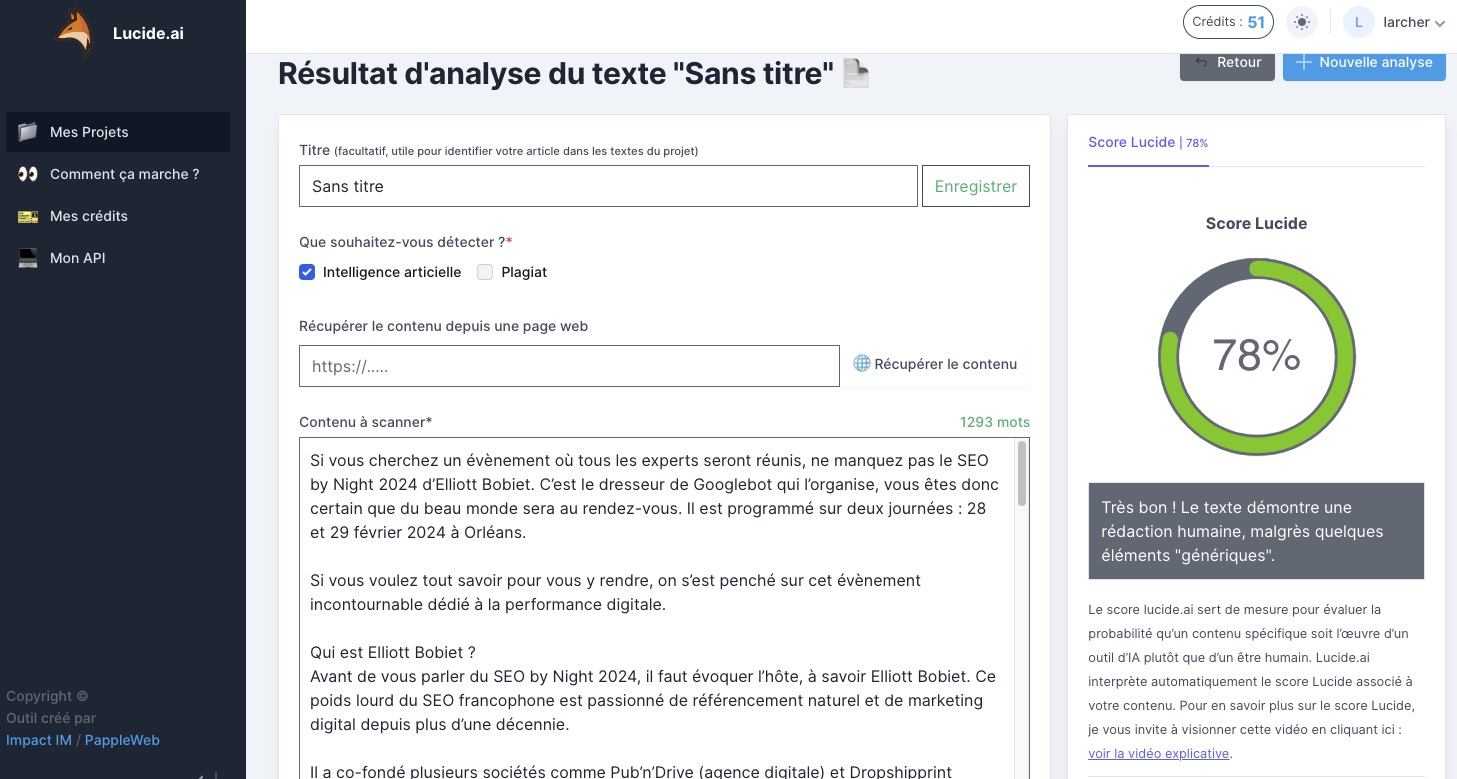

- L’article sur le SEO by Night 2024 qui est 100 % humain a un score de 78 %. Il est détecté comme rédaction humaine avec des passages génériques.

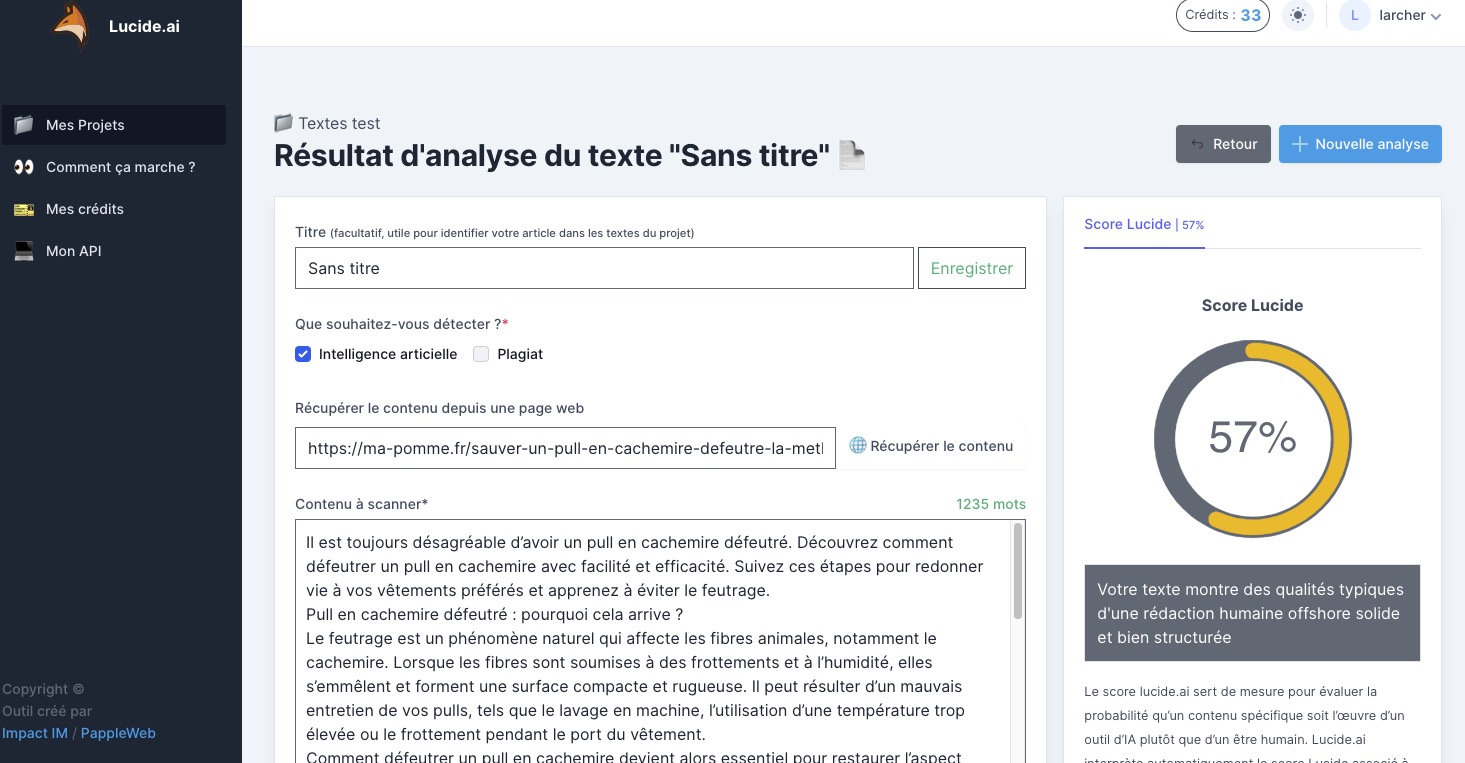

- Un article posté sur l’un de mes sites provenant de Textbulker sans aucune retouche obtient 51 %, il est détecté comme rédaction offshore.

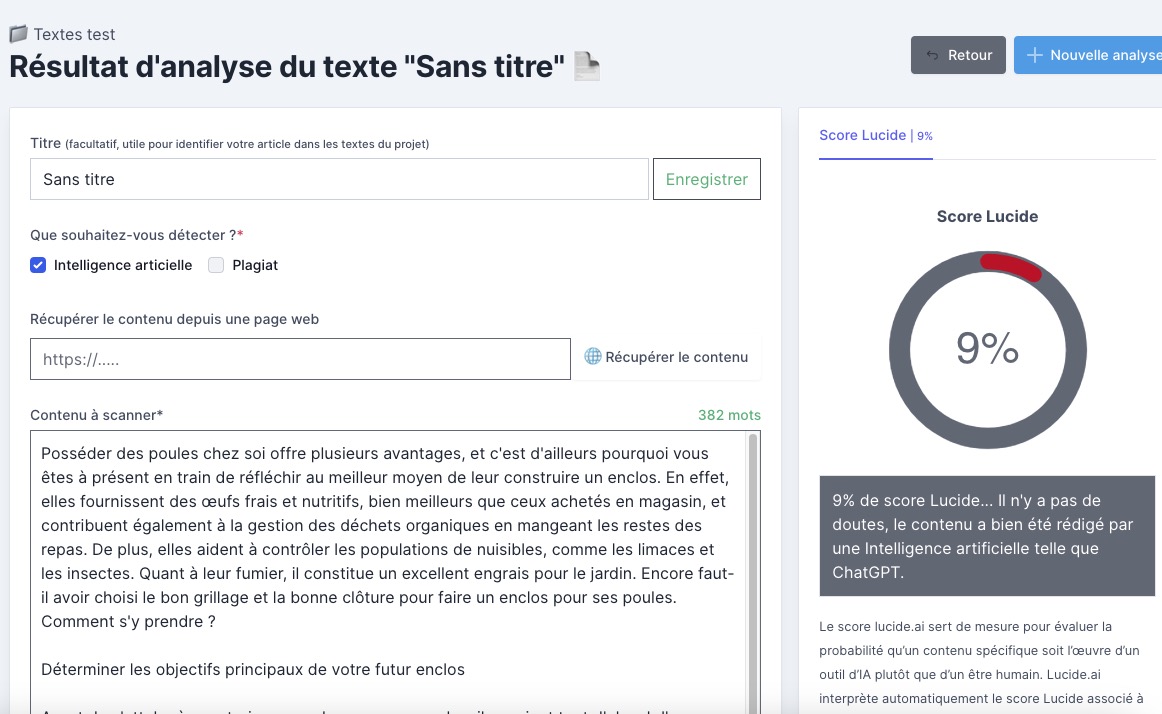

- Un article rédigé par un 2e rédacteur français obtient 9 % alors que l’article est 100 % humain.

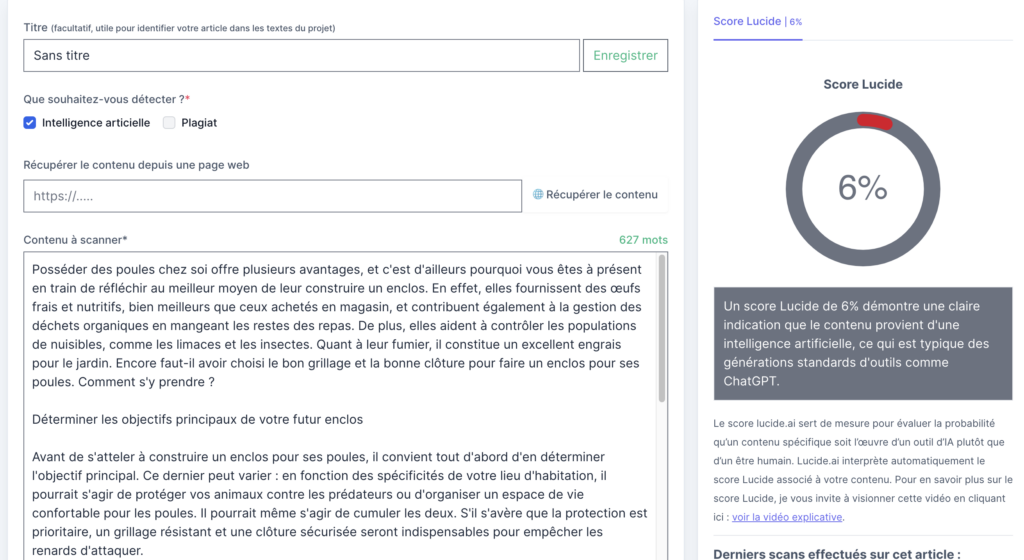

- Un article généré avec un prompt classique sur ChatGPT à 0 %, il est donc détecté en full IA.

- Mon article sur le test de SpeedyIndex est 100 % humain obtient 98 %, il est considéré comme full humain.

Par contre, j’ai un petit bémol à partager. Se focaliser uniquement sur cet outil pour détecter l’IA peut être problématique. Certains textes seront détectés comme « rédaction humaine offshore » comme celui de Textbulker alors qu’ils sont issus de l’IA. À contrario, un rédacteur offshore pourra rédiger son article sans s’aider de l’intelligence artificielle et il sera détecté de la même façon par Lucide. Dans ce cas de figure, le texte offshore est vraiment « humain ».

Attention à l’interprétation des scores « jaune »

J’en déduis que les scores les plus intéressants pour Lucide sont les plus bas et les plus élevés. Ensuite, arrive le débat de la qualité d’un article. Est-ce que le texte d’un rédacteur dont la qualité rédactionnelle est moindre peut être considéré comme de l’IA et inversement ? Il reste humain, mais la qualité est aussi faible que celle de ChatGPT ? Dans ce contexte, Lucide a une limite et c’est, je pense, tout à fait normal puisqu’il s’agit d’un outil basé sur l’intelligence artificielle. Une prise de recul pour l’interprétation des résultats est donc pertinente.

Qualité plutôt qu’IA ?

Alors, est-ce fiable ? Cela dépend de la qualité des contenus finalement.

- Lorsque le score est « vert », il s’agit d’une rédaction professionnelle selon l’outil, la qualité devrait être au rendez-vous.

- Si le score est « jaune », vous avez un texte type offshore (IA ou humain).

- Si le score est « rouge », vous obtenez un texte type IA (humain ou ChatGPT).

Si vous cherchez à classer les articles en « très bon » et « mauvais », Lucide peut vous aider, mais il sera difficile de détecter réellement l’IA pour les textes avec un score moyen ou faible.

Finalement, la question avec la rédaction Web s’articule surtout autour de la qualité des contenus puisque Google ne pénalise pas l’IA. J’estime que si vous obtenez des scores « vert » avec Lucide, vous publiez de bons ou très bons contenus. Par contre, avec les scores « jaune » et « rouge », la qualité ne sera pas celle escomptée. Et c’est de cette façon qu’il faut à mon sens utiliser cet outil sachant que chacun aura sa propre définition de la qualité d’un article.

Il est préférable selon moi d’utiliser Lucide comme un détecteur de qualité, mais il faut tout de même une relecture de votre part afin de vous forger votre propre idée par rapport à l’article.

Après une petite discussion avec Arthur, j’ai appris également que l’outil était utilisé par les écoles privées. Elles souhaitent savoir si un devoir rendu par les élèves a été écrit ou non avec de l’IA. Le monde de l’éducation semble friand de ce genre d’outils. Depuis l’arrivée de l’intelligence artificielle, les élèves et les étudiants ont clairement vu une opportunité avec ChatGPT ou d’autres outils du même genre comme POE qui permet d’utiliser Claude 2. Si certains utilisent l’IA pour rechercher des informations, d’autres délèguent complètement la rédaction des mémoires, des thèses. Lucide est alors utile pour les professeurs qui souhaitent détecter l’IA.

Et la suite ?

Quelques nouveautés ont été déployées. Une nouvelle vidéo a été publiée sur la home ! Vous avez de nouveaux packs pour les crédits et l’abonnement est passé à la trappe.

Pour accéder à l’API, c’est beaucoup plus simple et vous aurez une nouvelle interprétation des scores.

Quelques nouveautés sont arrivées sur https://t.co/Uw0LPuld0x 🦊

➡️ Nouvelle vidéo sur la home

➡️ Nouveaux packs de crédits

➡️ Fin de l’offre par abonnement !

➡️ Accès simplifié à l’API

➡️ Nouvelle interprétation des scoresL’affiliation 30% de revshare est toujours disponible… pic.twitter.com/R1QPKMSZGP

— Arthur (@ZalidanTV) February 21, 2024

Le test a été réalisé avant la mise à jour notamment des scores. Voici la nouvelle interprétation pour le texte sur les poules qui sortaient avec 9.

Petite info à prendre en considération : cet article est basé sur mon expérience vis-à-vis de l’outil et de mon vécu par rapport à la rédaction Web, ce n’est donc pas un avis universel, seulement le mien. Je suis ouverte à tout échange par rapport à vos propres tests sur mon compte Twitter par exemple (@JenniferLarcher).

Laisser un commentaire